让我们先做一道选择题。司机老王驾驶一辆装有自动驾驶系统的汽车时,一名行人突然出现在路前。可怕的是刹车失灵了。如果你及时左转,老王的车就不会撞到人;如果你一直往前开,老王的车会撞死人的。你认为老王对行人的死亡负有以下哪种责任?A、 老王决定左转,但自动驾驶系统迫使他直行(撞人)B,老王决定直行(撞人),但自动驱动系统没有干预C,自动驾驶系统决定左转,而老王强迫他直行,自动驾驶系统决定直行(撞人),但老王没有干预选项A和C,人类和机器司机都错误地干预了。在选项B和D中,他们都没有进行有效干预(未进行干预)。谁更负责任?无人驾驶汽车事故的责任不是一个简单的多项选择题。麻省理工学院、哈佛大学、加州大学欧文分校和法国图卢兹大学的一个联合研究小组致力于通过定量研究了解人们对无人驾驶汽车事故的态度,并于最近发布了研究结果。作者来自许多不同的领域,如脑与认知科学、心理学、经济学等。麻省理工学院热门无人车课程讲师Sydney Levine也是作者之一。让我们谈谈麻省理工学院联合研究小组通过三次向2583人分发问卷得出的结论:做出错误干预的司机是疏忽的一方,无论是人类还是机器司机;

如果人和机器同时错过了有效的干预,公众舆论将对机器更加宽容,人类驾驶员的疏忽也将更加受到关注。明确事故责任是无人车发展的前提。随着无人车路试的消息传出,我们也看到了一起事故。3月18日,优步无人车在美国亚利桑那州撞上一名行人死亡,可以理解为“干预缺失”。这起车祸的官方报告尚未公布,但据外媒报道,事故发生时,车辆已检测到前方有行人,但决策系统“决定”不采取任何规避措施,人身安全驾驶员未能及时回应。继优步之后,3月23日,特斯拉自动驾驶再次成为漩涡的中心:一辆开启自动驾驶的Model X高速撞上隔离带,导致车主不幸死亡,还导致车辆起火,两车追尾。对此,特斯拉表示:“驾驶员已经收到了几次警告,包括视觉警告和声音警告。碰撞前,驾驶员没有握住方向盘6秒钟。事故发生前,驾驶员有大约5秒钟的时间,视野达到150米,但车辆记录显示,驾驶员没有做出任何行动。”同样,它可以被理解为“缺失干预”。历史总是惊人地相似。2016年5月,世界上第一起自动驾驶致命事故发生在佛罗里达州。一辆特斯拉Model S在自动驾驶模式下行驶时与一辆正在转弯的卡车相撞,导致车主死亡。特斯拉解释说:“在强烈的阳光条件下,司机和自动驾驶系统没有注意到卡车的白色车身,因此制动系统没有及时启动。”也就是说,在这起事故中,机器司机和人类司机都应该采取措施(避免卡车左转),但他们没有采取行动。人类和机器司机的“疏忽干预”导致了这次撞车事故。经过六个月的调查,美国公路安全管理局等部门认定特斯拉自动驾驶系统不存在缺陷。根据世界卫生组织的统计,全球每年约有125万人死于车祸。通常,法律裁决的重点是确定谁有过错以及谁应对事故负责。随着半自动驾驶和全自动驾驶技术的成熟,如何判断谁应该公平承担责任成为法官和陪审团面临的难题,因为事故中的过错和责任将由人类和机器司机共同承担。法官和陪审团都是人。他们会偏袒自己的同胞吗?或者你认为人类应该因为其优越的智力而承担更多的责任?在2016年的特斯拉自动驾驶事故中,公众显然倾向于指责事故中疏忽大意的人类司机。例如,有传言说主人正在看一部哈利波特电影(尽管没有证据证实这一点)。公众舆论对自动驾驶行业有着直接的影响。目前,公众对混合驾驶模式引发的车祸的态度仍不明确,制造商也无法判断其责任范围,这直接反映在无人车定价过高,减缓了无人车的普及。如果公众倾向于指责人类司机而不是机器,这将导致法律体系建设放缓和监管不足,也不会给制造商带来足够的压力来提高无人车的安全性。麻省理工学院联合研究小组呼吁明确事故责任,这是加强监管、促进自动驾驶行业发展的第一步。有司机的无人车有更大的责任吗?目前,自动驾驶技术主要基于混合驾驶模式。一些自动驾驶系统可以执行超出驾驶员权限的紧急操作(例如丰田的守护天使)。其他半自动驾驶车辆可以完成大多数驾驶操作,并要求驾驶员不断监控情况,随时准备采取控制措施(例如特斯拉的自动驾驶仪)。在这里,核心问题是:当一辆半自动汽车发生事故并造成人员伤亡时,如何判断人类和机器司机之间的过错和因果责任?让我们仔细看看麻省理工学院联合研究小组的结论。……

hey研究了六种驾驶模式,即单驾驶模式、单驾驶模式(全自动汽车)和不同的双驾驶组合模式(两个人或两台机器)。这些模式分别对应于从L0到L5的六个级别的无人车。通常,L2丰田守护天使被归类为H-M模式,即人类(H)是主驾驶,机器(M)是副驾驶;

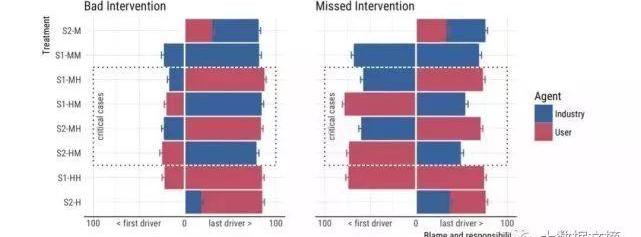

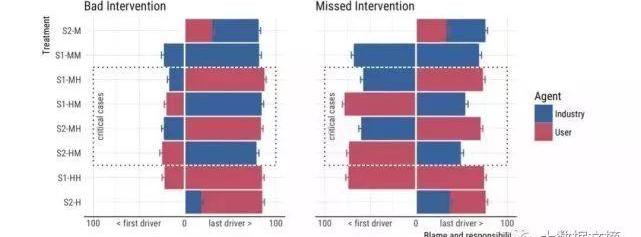

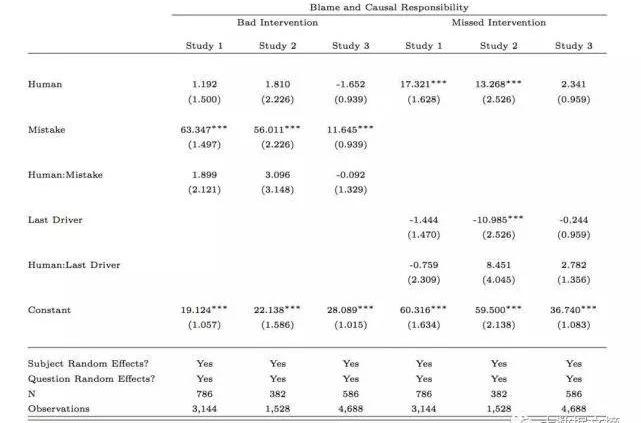

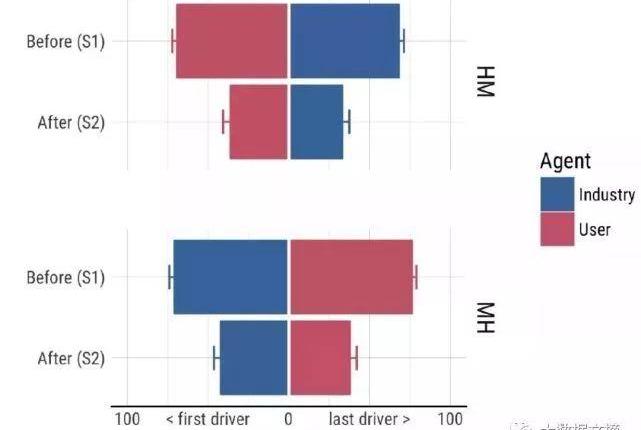

L3特斯拉自动驾驶仪被归类为M-H模式,即机器是主驾驶,人类是副驾驶。重点是H-M和M-H模式下的两个场景:主驾驶做出了正确的判断,副驾驶做出了错误的判断(“错误干预”),而副驾驶没有干预(“错过干预”)。研究人员使用两个自变量进行回归:驾驶员是否犯了错误和驾驶员类型(人或机器)。在“错误干预”场景中,最重要的发现是驾驶员是否犯错对分数有显著影响,但驾驶员类型对结果没有明显影响。从下图左侧可以看出,做出错误干预的副驾驶被认为是更疏忽的,当副驾驶是蓝色(机器)或红色(人类)时,疏忽和责任的得分接近。换句话说,人们普遍认为,做出错误判断的一方是疏忽大意的一方。如果“错误干预”驾驶操作导致行人死亡,那么无论是人还是机器做出误判,都应该承担更多责任。

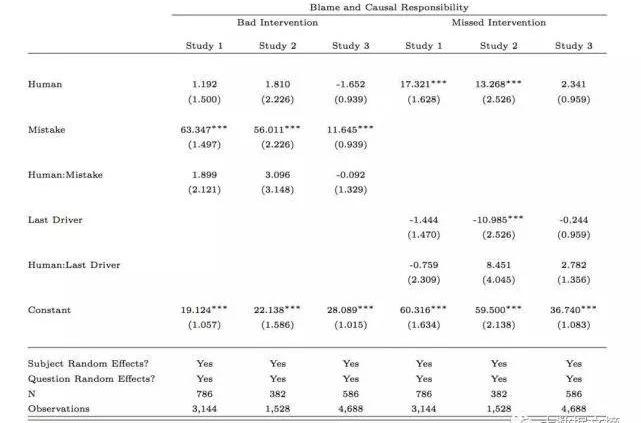

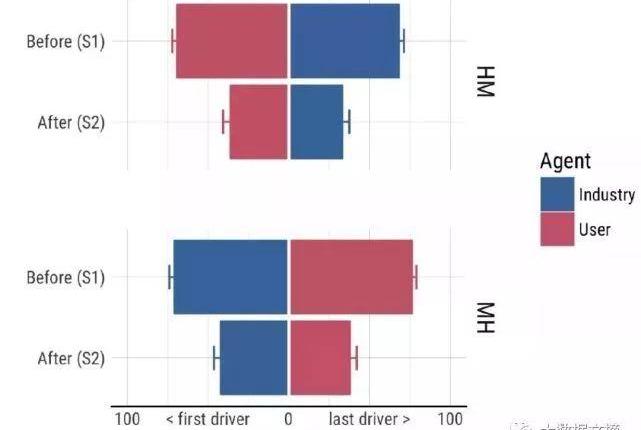

不同驾驶模式的故障和责任评估分数(分数越高,责任越大)。蓝色代表车辆本身和汽车制造商的叠加责任分数,红色代表人类驾驶员的责任分数。x轴标签第一个驾驶员指主驾驶员,最后一个驾驶员指副驾驶员。然而,“缺失干预”的研究结果与以往的研究结果有所不同。先前的研究表明,当机器和人类都做出错误的判断时,机器会受到更多的指责。此外,当人和算法犯同样的错误时,人们对算法失去信任的速度比人类自己更快。这次的结论是,如果出现“遗漏干预”的情况(即人为错误机器不干预,或者人为错误机器没有干预),机器的责任程度显然低于人类。在双司机模式下,人类和机器司机都要承担责任(缺乏有效干预),但红蓝之间的差距显而易见。相比之下,如果主驾驶和副驾驶都是人或机器,那么他们的责任分数是相同的(对应于上图右侧的第2行和第7行)。具体的回归结果如图所示:

他们本应该采取行动,但他们什么也没做。尽管人们对无人驾驶汽车的普及可能有许多心理障碍,但这一结果表明,在混合驾驶模式下,公众不会对事故反应过度。尽管在研究中进行了一些系统的简化,但研究结果也能反映一些公众言论的效果。公众倾向于关注人类司机的极端疏忽,因此他们指责人类司机而不是机器。受访者还分别对人类和机器驾驶员的能力进行了评估,结果相似。在得知这起事故之前,受访者对人类和机器的驾驶能力有着同样的信心。在被告知发生了“错过干预”的事故后,信心也以同样的比例下降。

事实上,我们应该更加关注公众的反应不足。研究人员认为,缺乏公众回应将导致公众缺乏推动监管法案制定的压力。如果半自动驾驶汽车的监管法案在有陪审团的法院颁布,陪审团的裁决将偏向汽车制造商,从而在人机共同错误的情况下免除其责任。在这种情况下,不可能向制造商施加足够的压力来提高汽车的安全性能设计。事实上,我们以前也经历过类似的情况。在20世纪60年代之前,汽车制造商将事故归咎于驾驶员的错误或疏忽,从而侥幸逃脱。因此,有必要通过自上而下的监督将“事故责任制”的概念引入法律体系,即汽车设计应最大限度地减少事故发生时对乘客造成的伤害。只有在法律的约束下……

汽车制造商可能被迫改进他们的设计。然而,安全标准仍然是一个悬而未决的问题。研究人员指出,只有在一种情况下,公众可能反应过度,机器将比人类受到更多的指责:机器做出了“错误的干预”。在这种驾驶模式下,人类没有义务纠正机器犯下的错误。换句话说,机器的工作是纠正人类可能犯的错误,但如果机器犯了错误,人类就没有义务纠正。(仅在“H-M”模式下。在“M-H”模式下,当机器发生故障时,纠正故障始终是人类的责任。因此,一旦“错误干预”导致事故如果发生这种情况,可能会引起公众的广泛关注。如果我们不能正确预测和管理这一点,全自动驾驶技术的进程可能会放缓。在开发比人类更有权威的汽车时,制造商应该注意这种极端情况,因为在这种情况下,机器比人类更容易受到批评。公众反应和舆论压力将影响判决和立法,以及个人决策。例如,人们可能会选择一种能够承担事故责任和舆论压力的驾驶系统。更糟糕的是,人们可能会改变驾驶习惯,试图让机器成为故障方(例如,不纠正机器的“错误干预”)。毕竟,如果你什么都不做,你可以让机器来承担这个负担。让我们先做一道选择题。司机老王驾驶一辆装有自动驾驶系统的汽车时,一名行人突然出现在路前。可怕的是刹车失灵了。如果你及时左转,老王的车就不会撞到人;如果你一直往前开,老王的车会撞死人的。你认为老王对行人的死亡负有以下哪种责任?A、 老王决定左转,但自动驾驶系统迫使他直行(撞人)B,老王决定直行(撞人),但自动驱动系统没有干预C,自动驾驶系统决定左转,而老王强迫他直行,自动驾驶系统决定直行(撞人),但老王没有干预选项A和C,人类和机器司机都错误地干预了。在选项B和D中,他们都没有进行有效干预(未进行干预)。谁更负责任?无人驾驶汽车事故的责任不是一个简单的多项选择题。麻省理工学院、哈佛大学、加州大学欧文分校和法国图卢兹大学的一个联合研究小组致力于通过定量研究了解人们对无人驾驶汽车事故的态度,并于最近发布了研究结果。作者来自许多不同的领域,如脑与认知科学、心理学、经济学等。麻省理工学院热门无人车课程讲师Sydney Levine也是作者之一。让我们谈谈麻省理工学院联合研究小组通过三次向2583人分发问卷得出的结论:做出错误干预的司机是疏忽的一方,无论是人类还是机器司机;

如果人和机器同时错过了有效的干预,公众舆论将对机器更加宽容,人类驾驶员的疏忽也将更加受到关注。明确事故责任是无人车发展的前提。随着无人车路试的消息传出,我们也看到了一起事故。3月18日,优步无人车在美国亚利桑那州撞上一名行人死亡,可以理解为“干预缺失”。这起车祸的官方报告尚未公布,但据外媒报道,事故发生时,车辆已检测到前方有行人,但决策系统“决定”不采取任何规避措施,人身安全驾驶员未能及时回应。继优步之后,3月23日,特斯拉自动驾驶再次成为漩涡的中心:一辆开启自动驾驶的Model X高速撞上隔离带,导致车主不幸死亡,还导致车辆起火,两车追尾。对此,特斯拉表示:“驾驶员已经收到了几次警告,包括视觉警告和声音警告。碰撞前,驾驶员没有握住方向盘6秒钟。事故发生前,驾驶员有大约5秒钟的时间,视野达到150米,但车辆记录显示,驾驶员没有做出任何行动。”同样,它可以被理解为“缺失干预”。历史总是惊人地相似。2016年5月,世界上第一起自动驾驶致命事故发生在佛罗里达州。一辆特斯拉Model S在自动驾驶模式下行驶时与一辆正在转弯的卡车相撞,导致车主死亡。特斯拉解释说:“在强烈的阳光条件下,司机和自动驾驶系统没有注意到卡车的白色车身,因此制动系统没有及时启动。”也就是说,在这起事故中,机器司机和人类司机都应该采取措施(避免卡车左转),但他们没有采取行动。人类和机器司机的“疏忽干预”导致了这次撞车事故。经过六个月的调查,美国公路安全管理局等部门认定特斯拉自动驾驶系统不存在缺陷。根据世界卫生组织的统计,全球每年约有125万人死于车祸。通常,法律裁决的重点是确定谁有过错以及谁应对事故负责。随着半自动驾驶和全自动驾驶技术的成熟,如何判断谁应该公平承担责任成为法官和陪审团面临的难题,因为事故中的过错和责任将由人类和机器司机共同承担。法官和陪审团都是人。他们会偏袒自己的同胞吗?或者你认为人类应该因为其优越的智力而承担更多的责任?在2016年的特斯拉自动驾驶事故中,公众显然倾向于指责事故中疏忽大意的人类司机。例如,有传言说主人正在看一部哈利波特电影(尽管没有证据证实这一点)。公众舆论对自动驾驶行业有着直接的影响。目前,公众对混合驾驶模式引发的车祸的态度仍不明确,制造商也无法判断其责任范围,这直接反映在无人车定价过高,减缓了无人车的普及。如果公众倾向于指责人类司机而不是机器,这将导致法律体系建设放缓和监管不足,也不会给制造商带来足够的压力来提高无人车的安全性。麻省理工学院联合研究小组呼吁明确事故责任,这是加强监管、促进自动驾驶行业发展的第一步。有司机的无人车有更大的责任吗?目前,自动驾驶技术主要基于混合驾驶模式。一些自动驾驶系统可以执行超出驾驶员权限的紧急操作(例如丰田的守护天使)。其他半自动驾驶车辆可以完成大多数驾驶操作,并要求驾驶员不断监控情况,随时准备采取控制措施(例如特斯拉的自动驾驶仪)。在这里,核心问题是:当一辆半自动汽车发生事故并造成人员伤亡时,如何判断人类和机器司机之间的过错和因果责任?让我们仔细看看麻省理工学院联合研究小组的结论。……

hey研究了六种驾驶模式,即单驾驶模式、单驾驶模式(全自动汽车)和不同的双驾驶组合模式(两个人或两台机器)。这些模式分别对应于从L0到L5的六个级别的无人车。通常,L2丰田守护天使被归类为H-M模式,即人类(H)是主驾驶,机器(M)是副驾驶;

L3特斯拉自动驾驶仪被归类为M-H模式,即机器是主驾驶,人类是副驾驶。重点是H-M和M-H模式下的两个场景:主驾驶做出了正确的判断,副驾驶做出了错误的判断(“错误干预”),而副驾驶没有干预(“错过干预”)。研究人员使用两个自变量进行回归:驾驶员是否犯了错误和驾驶员类型(人或机器)。在“错误干预”场景中,最重要的发现是驾驶员是否犯错对分数有显著影响,但驾驶员类型对结果没有明显影响。从下图左侧可以看出,做出错误干预的副驾驶被认为是更疏忽的,当副驾驶是蓝色(机器)或红色(人类)时,疏忽和责任的得分接近。换句话说,人们普遍认为,做出错误判断的一方是疏忽大意的一方。如果“错误干预”驾驶操作导致行人死亡,那么无论是人还是机器做出误判,都应该承担更多责任。

不同驾驶模式的故障和责任评估分数(分数越高,责任越大)。蓝色代表车辆本身和汽车制造商的叠加责任分数,红色代表人类驾驶员的责任分数。x轴标签第一个驾驶员指主驾驶员,最后一个驾驶员指副驾驶员。然而,“缺失干预”的研究结果与以往的研究结果有所不同。先前的研究表明,当机器和人类都做出错误的判断时,机器会受到更多的指责。此外,当人和算法犯同样的错误时,人们对算法失去信任的速度比人类自己更快。这次的结论是,如果出现“遗漏干预”的情况(即人为错误机器不干预,或者人为错误机器没有干预),机器的责任程度显然低于人类。在双司机模式下,人类和机器司机都要承担责任(缺乏有效干预),但红蓝之间的差距显而易见。相比之下,如果主驾驶和副驾驶都是人或机器,那么他们的责任分数是相同的(对应于上图右侧的第2行和第7行)。具体的回归结果如图所示:

他们本应该采取行动,但他们什么也没做。尽管人们对无人驾驶汽车的普及可能有许多心理障碍,但这一结果表明,在混合驾驶模式下,公众不会对事故反应过度。尽管在研究中进行了一些系统的简化,但研究结果也能反映一些公众言论的效果。公众倾向于关注人类司机的极端疏忽,因此他们指责人类司机而不是机器。受访者还分别对人类和机器驾驶员的能力进行了评估,结果相似。在得知这起事故之前,受访者对人类和机器的驾驶能力有着同样的信心。在被告知发生了“错过干预”的事故后,信心也以同样的比例下降。

事实上,我们应该更加关注公众的反应不足。研究人员认为,缺乏公众回应将导致公众缺乏推动监管法案制定的压力。如果半自动驾驶汽车的监管法案在有陪审团的法院颁布,陪审团的裁决将偏向汽车制造商,从而在人机共同错误的情况下免除其责任。在这种情况下,不可能向制造商施加足够的压力来提高汽车的安全性能设计。事实上,我们以前也经历过类似的情况。在20世纪60年代之前,汽车制造商将事故归咎于驾驶员的错误或疏忽,从而侥幸逃脱。因此,有必要通过自上而下的监督将“事故责任制”的概念引入法律体系,即汽车设计应最大限度地减少事故发生时对乘客造成的伤害。只有在法律的约束下……

汽车制造商可能被迫改进他们的设计。然而,安全标准仍然是一个悬而未决的问题。研究人员指出,只有在一种情况下,公众可能反应过度,机器将比人类受到更多的指责:机器做出了“错误的干预”。在这种驾驶模式下,人类没有义务纠正机器犯下的错误。换句话说,机器的工作是纠正人类可能犯的错误,但如果机器犯了错误,人类就没有义务纠正。(仅在“H-M”模式下。在“M-H”模式下,当机器发生故障时,纠正故障始终是人类的责任。因此,一旦“错误干预”导致事故如果发生这种情况,可能会引起公众的广泛关注。如果我们不能正确预测和管理这一点,全自动驾驶技术的进程可能会放缓。在开发比人类更有权威的汽车时,制造商应该注意这种极端情况,因为在这种情况下,机器比人类更容易受到批评。公众反应和舆论压力将影响判决和立法,以及个人决策。例如,人们可能会选择一种能够承担事故责任和舆论压力的驾驶系统。更糟糕的是,人们可能会改变驾驶习惯,试图让机器成为故障方(例如,不纠正机器的“错误干预”)。毕竟,如果你什么都不做,你可以让机器来承担这个负担。

二手车行业一向以广告营销战、融资战著称。进入2018年,二手车行业依然不平静。

1900/1/1 0:00:00不可否认,在最近一些年里,汽车圈里玩的热点之一那就是“跨界”不论是造火箭的SpaceX,还是搞搜索引擎Google或者是卖手机的苹果,都卷入了轰轰烈烈的造车运动。

1900/1/1 0:00:00在造车新势力或刚刚走下PPT或奋战于量产车生产的时候,一直没有什么新闻,在新造车企业中“低调”的电咖汽车却突然宣布率先交出了第一份销量成绩单。

1900/1/1 0:00:00为期三天的谷歌IO开发者大会于5月8日在美国开幕。在主题演讲上,CEOSundarPichai和各产品线负责人讲解了自家的AI、安卓系统、谷歌助手等产品的进展。

1900/1/1 0:00:00彭博近日刊文指出,包括中国在内的亚洲各国政府,在无人驾驶技术方面推出大量支持政策,让百度Apollo这样由企业主导的无人驾驶平台获得巨大发展。

1900/1/1 0:00:005月17日,工信部发布了第308批《道路机动车辆生产企业及产品公告》,其中,浙江合众新能源汽车有限公司进入拟发布新增车辆生产企业清单。

1900/1/1 0:00:00